Spis treści

Wszelkie koncepcje architektoniczne rozpoczynają się od szkiców oraz rozmów i dyskusji, zaś istotną część każdego z projektów stanowią wizualizacje. Czy zastosowanie generatorów text-to-image (TTI) opartych o Deep Learning (DL), których gwałtowny rozwój obserwujemy, może więc naturalnie zmienić sposób, w jaki projektujemy? W niniejszym artykule opisuję najbardziej popularne generatory TTI, które pokazują aktualny poziom rozwoju technologii.

ML, DL, ANN, NLP, czyli kilka definicji

Zacznijmy od kilku krótkich definicji, które pozwolą lepiej zrozumieć zagadnienie. Machine Learning (ML) jest szeroką dziedziną AI, obejmującą wszelkie procesy i algorytmy, które mogą, bez uprzedniego programowania, przeanalizować i rozpoznać wzorce w danych wejściowych i wyciągnąć wnioski. W procesie „trenowania”, w miarę zdobywania nowego doświadczenia, algorytmy uczą się i doskonalą. Wdrożenia ML obejmują systemy analiz danych finansowych, automatyzację procesów, zaś w życiu codziennym ML znajdują zastosowanie na przykład w funkcji wirtualnych asystentów.

Deep Learning (DL) stanowi dziedzinę Machine Learning, która do uczenia maszynowego wykorzystuje Artifical Neural Network (ANN), czyli sztuczne sieci neuronowe. Inspiracją dla ANN jest biologiczna sieć neuronowa mózgu, zaś procesy uczenia się takich sieci są znacznie bardziej wydajne. DL umożliwia komputerom rozwiązywanie skomplikowanych problemów niezależnie od różnorodności czy organizacji używanych zbiorów danych, a proces uczenia się przypomina procesy biologiczne.

Natural Language Processing (NLP) wykorzystuje z kolei zaawansowane algorytmy konwersji nieustrukturyzowanego języka potocznego do formatu zrozumiałego dla komputerów, co znajduje zastosowanie m.in. w asystentach głosowych takich jak Alexa.

Computer Vision (CV) obejmuje natomiast rozpoznawanie i interpretację obrazów i znalazło zastosowanie choćby w samochodach autonomicznych lub diagnostyce medycznej.

Generatory i dyskryminatory

Generatory text-to-image stanowią przełomową technologię AI, która łączy rozumienie języka z możliwościami syntezy obrazów. Na podstawie opisu (promptu) modele sieci neuronowych (ANN) i dedykowane Convolutional Neural Networks (CNN), wytrenowane na danych wizualnych, mogą wygenerować lub modyfikować obrazy. Prawdziwym przełomem w tej dziedzinie było zastosowanie Generative Adversarial Network (GAN), opisanych teoretycznie przez Iana Goodfellowa w 2014 roku. Model uczenia GAN oparty jest o dwie konkurujące, samouczące sieci neuronowe. Pierwsza z nich, zwana generatorem, tworzy nowe obrazy, zaś druga, znana jako dyskryminator, porównuje je do oryginałów. W ten sposób możliwe jest stosunkowo szybkie wytrenowanie wyrafinowanego modelu TTI zdolnego do tworzenia fotorealistycznych obrazów.

W 2018 roku Nvidia Research udowodniła funkcjonalność GAN poprzez wdrożenie eksperymentalnego modelu StyleGan. Variational Autoencoders (VAEs) stanowią kolejny model funkcjonujący w oparciu o matematyczną koncepcję Latent Space, który pozwala na zachowanie wysokiej precyzji generowanych danych i zachowanie większej kontroli nad ostatecznym rezultatem. Wyjątkowo dobre efekty uzyskują także modele Diffusion, które generują obrazy z wykorzystaniem procesu uczenia opartego o dekonstrukcję i ponowną kreację z użyciem szumu Gaussa.

Liczne eksperymenty, wykorzystujące m.in. opisane powyżej modele, doprowadziły w 2021 roku do wysypu różnego rodzaju modeli generatywnych, wśród których wyróżniają się szczególnie: DALL-E, Midjourney i Stable Diffusion.

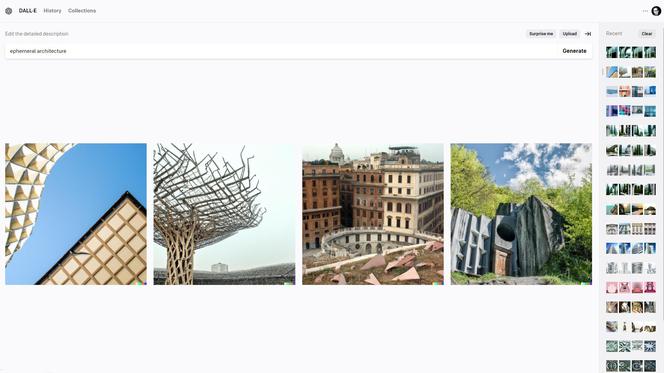

DALL-E

DALL-E i DALL-E 2, stworzone przez OpenAI, wykorzystują sieć neuronową opartą o model GPT-3 z zastosowaniem metodologii CLIP. Pierwotnie DALL-E wykorzystywał dVAE, jednak już wersja 2 opiera się o modele Diffusion. Łącząc technologię NLP i CV, model jest w stanie wygenerować obrazy na podstawie opisu podanego przez użytkownika. Dzięki intuicyjnemu interfejsowi DALL-E 2 jest wyjątkowo prosty w obsłudze i pozwala osobom prawie bez doświadczenia szybko uzyskać satysfakcjonujące efekty. Szczególnie dobrze sprawdza się w stylizacjach, pozwala także na ograniczoną edycję wygenerowanych obrazów dzięki wykorzystaniu inpaint (korekta fragmentu) i outpaint (rozszerzenie obrazu). Rozdzielczość natywna wynosi 1024 x 1024 pikseli.

i

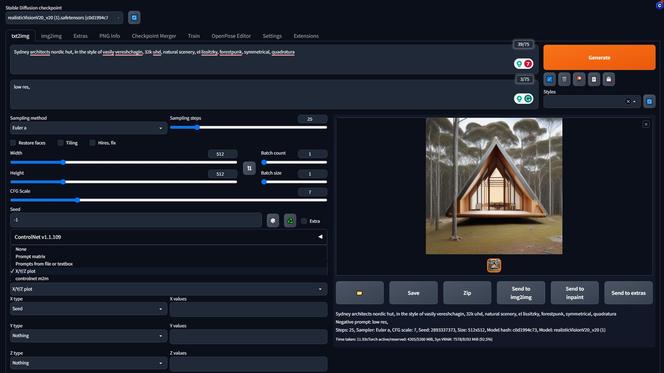

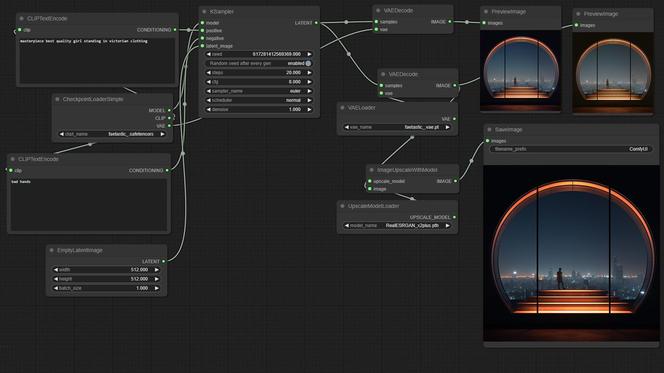

Stable Diffusion

Opublikowany przez Stability.AI model open-source Stable Diffusion pozwala na syntezę obrazów z wykorzystaniem wspomnianego wcześniej Diffusion Model. Możliwe jest wykorzystanie zarówno promptów pozytywnych, jak i negatywnych, a także inpainting i outpainting. Dzięki odpowiednim interfejsom użytkownika – w tym interfejsom, które można zainstalować lokalnie na komputerze (np. Automatic1111 lub ComfyUI) – można zachować pełną kontrolę nad procesem generowania obrazów poprzez zastosowanie ControlNet oraz inpainting. Możliwe jest także „wytrenowanie” własnych modeli lub wykorzystanie istniejących z bogatej biblioteki. Najnowsza wersja SDXL pozwala na generowanie obrazów o rozdzielczości 1024 x 1024 pikseli, którą można zwiększyć przy wykorzystaniu wbudowanych upscalerów.

i

i

Midjourney

Stosunkowo nową technikę generowania obrazów zaprezentowało niezależne laboratorium badawcze Midjourney. Dostępny poprzez Discorda system pozwala na ich tworzenie z wykorzystaniem modeli GAN, zaś aktualna wersja modelu to 5.2. Pomimo niewielkich możliwości manipulacji, na tle innych modeli wyróżnia go wyjątkowa, fotorealistyczna jakość obrazów o wielkości natywnej 1024 x 1024 pikseli. Ze względu na sposób generowania treści, stosunkowo łatwo uzyskać atrakcyjne wizualnie rezultaty, przy czym niekiedy trudniejsze bywa uzyskanie zgodności z promptem.

i

W dobie dynamicznego rozwoju technologii sztucznej inteligencji, branża architektoniczna również zaczyna dostrzegać potencjał drzemiący w nowoczesnych narzędziach. Architekt Daniel Libeskind powiedział „Architektura jest językiem i potrzebujesz odpowiednich umiejętności, aby się nim posługiwać”. Wraz z Deep Learning oraz generatorami text-to-image otrzymujemy nowe narzędzia mogące zmienić sposób, w jaki komunikowane i rozwijane będą idee.

DALL-E, Stable Diffusion czy Midjourney otwierają nowe horyzonty dla twórców, umożliwiając wyrafinowane i precyzyjne tworzenie obrazów na bazie słów. Na tym etapie rozwoju wykorzystanie ich w projektowaniu architektury wciąż pozostaje eksperymentalne, pełniąc rolę nowoczesnego szkicownika, który co najwyżej może przydać się w poszukiwaniu inspiracji. Choć potencjał technologii jest ogromny, wiele aspektów, w tym kwestie etyczne i konsekwencje estetyczne, są jeszcze niezbadane. Warto śledzić jej aktualny rozwój, aby znaleźć obszary zastosowań, które będą pożyteczne dla projektantów i procesu projektowego.